またまたSEOを勉強していくとrobots.txtという言葉が出てくると思いますが、robots.txtと言われても意味が分からない人が多いですよね。

SEOの内部対策で設定しておく1つの施策なのですが、この記事では分かりやすいrobots.txtの意味と書き方を紹介していきます。

robots.txtは正しい知識が無い状態で間違って記述してしまうとSEOに大きな影響を及ぼしてしまいます。

最初の頃は、基本形だけにしておきましょう。

SEO内部対策のステップ

サイトマップとは|XMLサイトマップを送信する6つのメリット

URLの正規化|SEOに重要なURL正規化の簡単なやり方教えます

robots.txtの書き方|誰でも1クリックで記述できる方法←今この記事

常時SSL化(https化)とは|SEOに必須な理由と設定の方法

モバイルフレンドリーとは?|チェックからテスト方法まで解説します

SEOに強いタイトルとは?文字数とキーワード重複、検索意図を解説

ディスクリプション(description)|SEO効果の高い設定とは

見出しタグ(hタグ)|h1タグ・h2タグ・h3タグの上手な使い方

alt属性|SEOに効果的な書き方を解説(alt属性の例あり)

ブログのカテゴリー|SEOに強い構造にするためのカテゴリー分け

内部リンク|SEOに強くなる正しい貼り方と確認方法まで解説します

勝つためのSEOキーワードの選定|上位表示するための効果的な手順

-

-

AFFINGER6はSEOに強いのか?評判を特典付きでレビュー

WordPressでサイトを作る意味は「SEOで検索上位に上げるため」の他には理由がありませんね。 しかし、テーマが無数にありすぎて、とりあえず最初から付いているTwenty ninet ...

続きを見る

<クリックできる目次>

robots.txtとは

robots.txtとは、クローラーの巡回を指示するためのファイルです。

指示しない場合、クローラーは全てに対して巡回しますので、WEBサイトの中で必要の無い部分をクローラーが巡回しないように指定したりできるということなのですね。

robots.txtはクローラーの巡回を制限するためのファイルですので、通常は設定する必要はありません。

WEBサイトの規模が大きかったり、複雑な構造になってしていたり、サーバーの負荷が大きくなり、パフォーマンスに影響する場合には巡回が不要なWEBページを指定したり、特定のクローラーの巡回を制限したりすることができるということです。

しかし、これは難しい部分でもありますので、最初の頃にはこれだけ設定しておけばOKという書き方を書いていきます。

robots.txtの書き方

robots.txtの書き方には基本的な形が決まっています。

robots.txtの基本形

User-agent: *

Disallow: /wp/wp-admin/

Allow: /wp/wp-admin/admin-ajax.php

Sitemap: https://sample.com/sitemap.xml

この形なのですが、意味を説明しておきます。

- User-agent: *→対象となるクローラー

- Disallow:→許可しない

- Allow:→許可する

これだけ意味を覚えておけばOKです。

これで先ほどの記述の意味を解説しますと次のようになります。

robots.txtの意味

User-agent: *→全てのクローラーが対象

Disallow: /wp/wp-admin/→あなたのサイトの管理画面は巡回を許可しない

Allow: /wp/wp-admin/admin-ajax.php→あなたのサイトの管理画面のJavaScriptやCSSを許可する

Sitemap: https://sample.com/sitemap.xml→あなたのサイトのサイトマップの位置を指定します

この記述だけでOKなのですが、実際にどこに記述するのか分からなくて困りますよね?

【robots.txtの基本形】プラグインを使った書き方

このrobots.txtの一番簡単な書き方はプラグインで設定することです。

プラグインの名前は「All in One SEO Pack」です。

All in One SEO Packでのrobots.txtの書き方

「All in One SEO Pack」でのrobots.txtの書き方を解説していきます。

まず「All in One SEO Pack」をインストールしたら、「機能」のなかで「フリー」と書いてあるものは全て有効化してください。

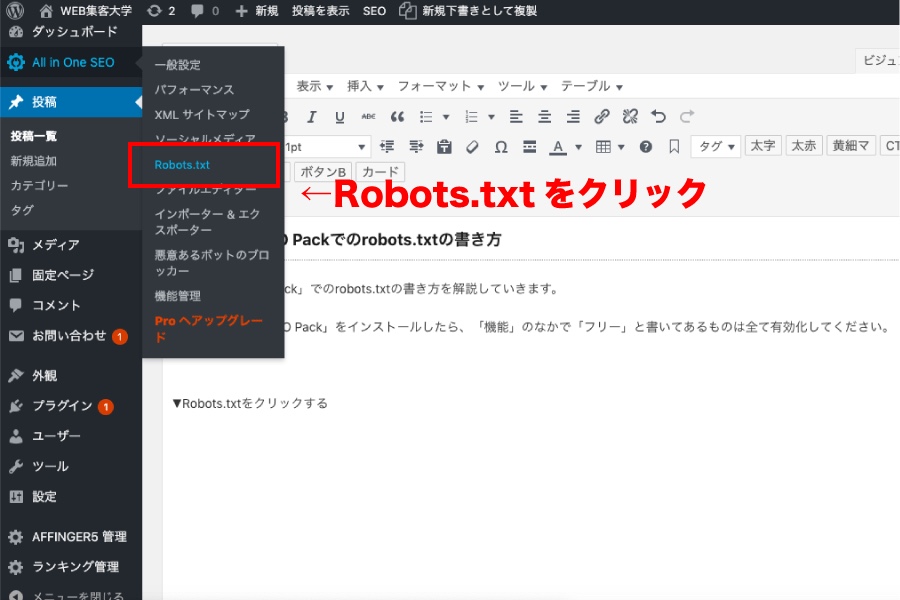

▼Robots.txtをクリックする

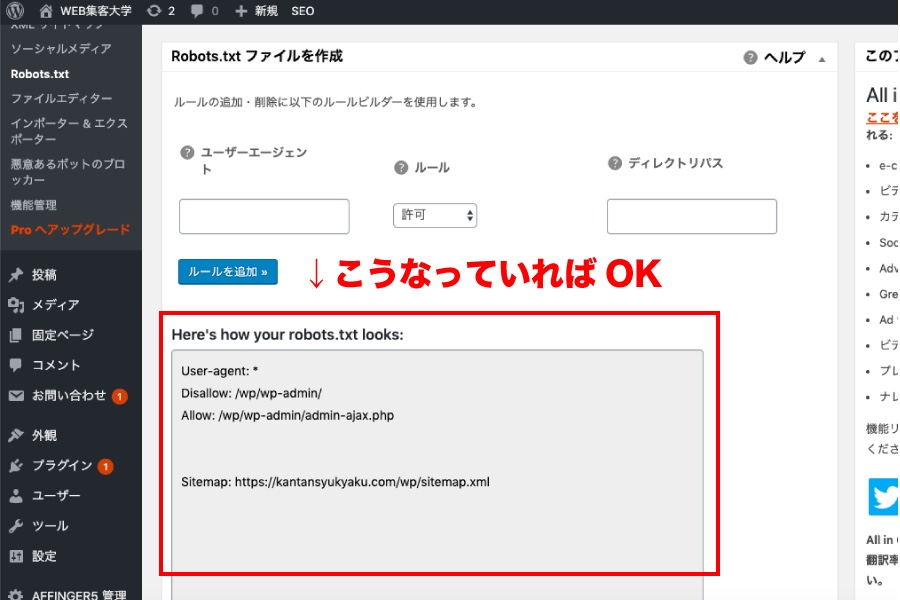

▼プラグインの機能が有効化されているとこうなっている

意味は先ほどの説明の通りです。

この記述になっていればOKなのですが、要はプラグイン「All in One SEO Pack」をインストールして「Robots.txt」の機能を有効化するだけで勝手にここまで記述されてしまいますので、あなたは何もする必要はありません。

簡単ですよね。

robots.txtの書き方まとめ

robots.txtはクローラーの巡回を指示したり制限したりするファイルのことです。

正しい知識を持たずにrobots.txtを設定してしまうとGoogleからの評価を下げてしまう場合もありますので、基本的な意味だけ理解して基本形だけ記述しておくのが良いでしょう。

最も簡単なrobots.txtの書き方はプラグイン「All in One SEO Pack」をインストールして「機能」を有効化するだけというやり方です。

追記:ALL in One SEO以外でのrobots.txtの書き方

2021年10月現在、私はAll in One SEOを削除しました。

理由は、最近のWordPressテーマがSEO内部対策の設定が優秀だからです。

テーマがほとんどの設定が施策済みとなると、逆にAll in One SEOなどのSEOプラグインを入れると干渉してしまい不利になります。

昔はWordPressでSEO設定しようとすれば、All in One SEOでバズ部さんの出した記事通りに設定することで完璧な内部対策ができたのですが、現在はWordPressのアップデートによりテーマがどんどん優秀になってきています。

私が使っているAFFINGER6のテーマで出来ないことは、

- サイトマップの作成

- robots.txtの設定

ぐらいであり、そこだけ補えばAll in One SEOは必要なくなり、重いプラグインは不利になります。

さらにはAll in One SEOのテーマとの干渉により不具合が生じてきたことが理由です。

現時点での一番簡単なrobots.txtの書き方

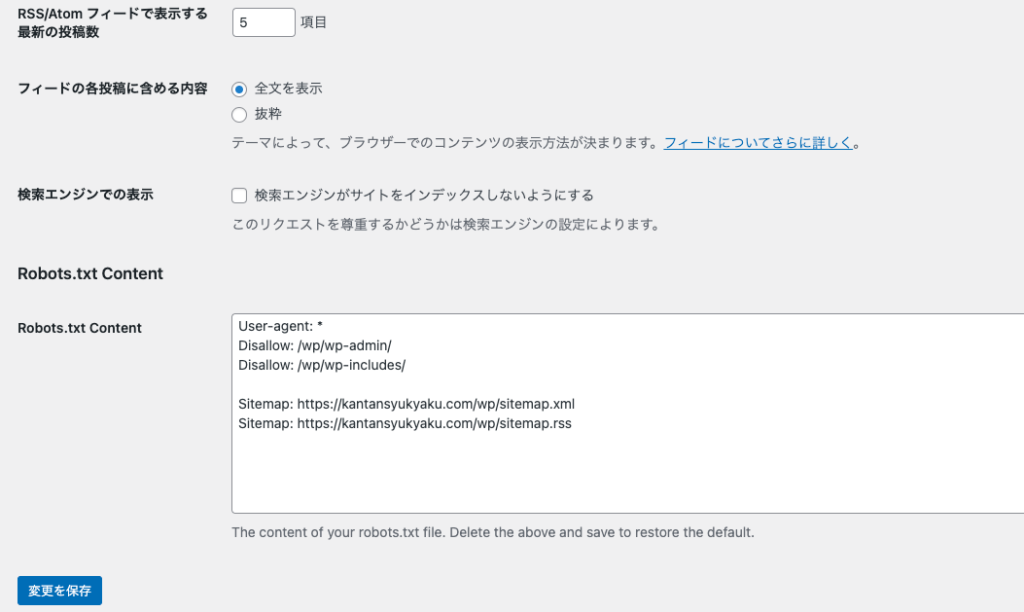

プラグイン「WP Robots Txt」をダウンロードします。

有効化したら、

WordPressの一般設定

↓

表示設定をクリックします

表示設定の画面に次のrobots.txtの設定項目が追加されています。

↓↓

ここに次をコピーして貼り付ければOKです。

Sitemap: https://kantansyukyaku.com/wp/sitemap.xml

Sitemap: https://kantansyukyaku.com/wp/sitemap.rss

追記2:内部対策は最初からテーマに任せてしまったほうが良い

-

-

AFFINGER6はSEOに強いのか?評判を特典付きでレビュー

WordPressでサイトを作る意味は「SEOで検索上位に上げるため」の他には理由がありませんね。 しかし、テーマが無数にありすぎて、とりあえず最初から付いているTwenty ninet ...

続きを見る

SEO対策の関連記事

-

-

SEO対策のやり方36選|基本を初心者向けに徹底解説【最新】

最新のSEO対策のやり方を初心者向けにわかりやすく基本をまとめました。 正直、SEO対策って調べていても、どの記事も初心者には専門用語満載でかりにくいですよね。 私も非常に苦労しましたの ...

続きを見る

-

-

コンテンツビジネスの始め方を解説!商品を販売した具体例120選

あなたは、もしかしたら現在、ご自身の商品やサービスを販売しようと頑張っているのかもしれません。 にもかかわらず、売れていない状況だとしたら、この記事はお役に立てますので、ぜひ、参考にして ...

続きを見る

-

-

AFFINGER6はSEOに強いのか?評判を特典付きでレビュー

WordPressでサイトを作る意味は「SEOで検索上位に上げるため」の他には理由がありませんね。 しかし、テーマが無数にありすぎて、とりあえず最初から付いているTwenty ninet ...

続きを見る

-

-

Danganページビルダーとは?プラグインの特徴と使い方を解説

LPを知らない方のために、LPはランディングページのことです。 ホームページとは違い、WEB上に置いておく1枚のチラシのようなものだと思っていただけば良いです。 基本的に、縦長にスクロー ...

続きを見る

-

-

LP作成テンプレート カラフルの感想|初心者でも簡単で使いやすい

あなたが、ネットで集客して商品を売るためには2種類のページが必要になりますね。 メルマガに登録してもらうためのページ 商品やサービスを購入してもらうためのページ   ...

続きを見る